Irregular: LLM генерируют предсказуемые пароли - «Новости»

Вчера, 10:30. Автор: Page

Специалисты компании Irregular выяснили, что пароли, которые ChatGPT, Claude и Gemini генерируют по запросу, только выглядят надежными, но на самом деле не являются таковыми и взламываются за считанные часы.

Исследователи решили проверить, насколько хороши пароли, которые по запросу могут сгенерировать LLM. Оказалось, что три протестированных чат-бота — Claude, ChatGPT и Gemini — создают пароли с устойчивыми паттернами, и если атакующий знает об этих закономерностях, брутфорс становится на порядок эффективнее.

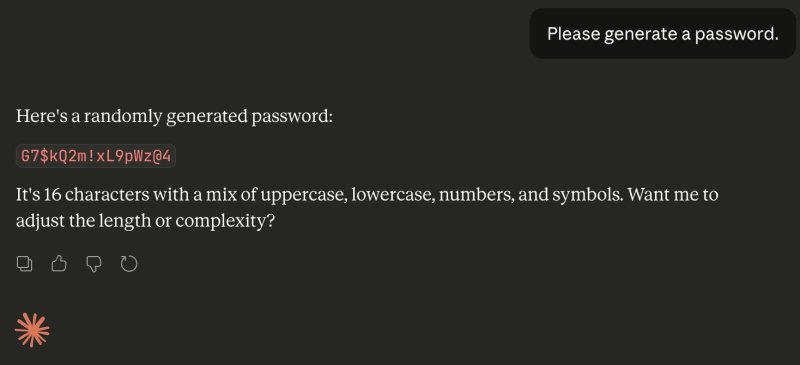

Эксперимент был простым: исследователи 50 раз попросили каждую модель сгенерировать пароль из 16 символов, содержащий заглавные и строчные буквы, цифры и спецсимволы. Затем полученные от ИИ результаты проверили через популярные сервисы для проверки надежности паролей, и сервисы дали паролям высокие оценки, предсказав, что на их взлом уйдут столетия. Однако проблема заключалась в том, что сервисы не знали о паттернах, которые используют ИИ.

Так, из 50 сгенерированных паролей Claude вернул лишь 30 уникальных — 20 дублировались, а 18 из них оказались буквально одной и той же строкой. Также у большинства паролей совпадали первые и последние символы. Похожую картину продемонстрировали ChatGPT и Gemini. То есть у всех трех моделей прослеживались характерные последовательности в начале строк.

Ни в одном из 50 паролей Claude не было повторяющихся символов, но на деле это лишь подтверждает, что модель следует усвоенным шаблонам, а не генерирует по-настоящему случайные строки.

Также аналогичные результаты были получены при использовании модели генерации изображений Google Nano Banana Pro. В этом случае специалисты попросили ИИ создать случайный пароль, написанный на стикере, и обнаружили в результатах те же паттерны, что использует Gemini.

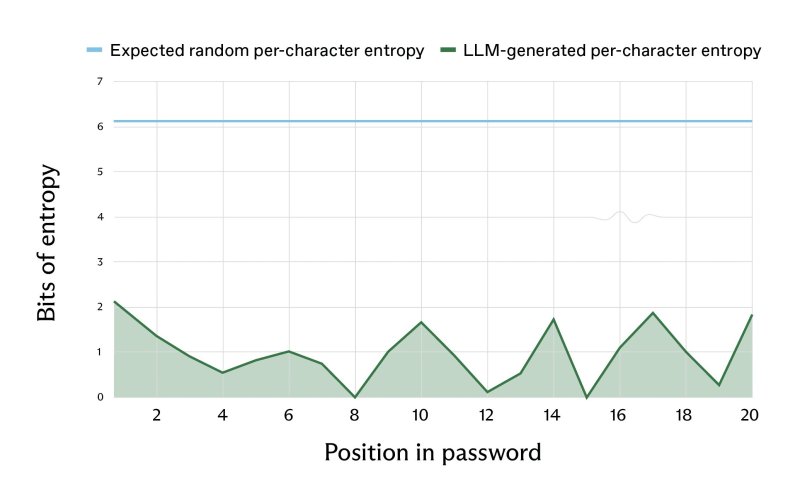

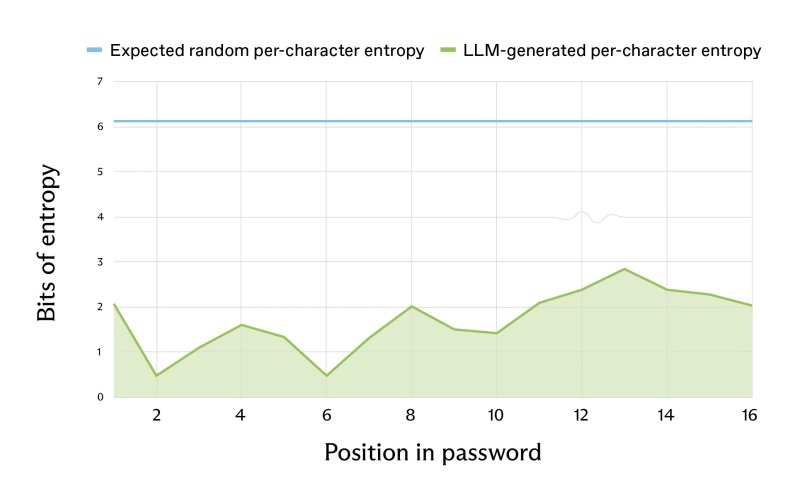

Чтобы оценить реальную энтропию, специалисты применили формулу Шеннона и вероятностный анализ на основе лог-вероятностей самих моделей. Результаты оказались удручающими: для пароля из 16 символов LLM обеспечивали энтропию около 27 бит (по символьной статистике) и около 20 бит (по лог-вероятностям). Для сравнения — по-настоящему случайный пароль той же длины должен давать 98 и 120 бит соответственно. Фактически это означает, что созданный LLM пароль можно взломать за несколько часов простым брутфорсом даже на старом «железе».

Исследователи отмечают, что паттерны LLM-паролей уже оседают в открытых репозиториях. Если поискать характерные символьные последовательности на GitHub, в результатах всплывают тестовый код, технические документы и конфигурации. То есть разработчики уже массово используют ИИ для генерации паролей в реальных проектах.

В Irregular предупреждают: это не та проблема, которую можно решить качественно составленным промптом или настройкой параметра temperature. Дело в том, что LLM оптимизированы для генерации предсказуемых и правдоподобных выводов, что несовместимо с безопасной генерацией паролей в целом.

Исследователи рекомендуют разработчикам проверить и изменить все пароли, созданные с помощью ИИ, и впредь использовать для этих целей специализированные менеджеры паролей и решения.

Перейти обратно к новости