Учебник CSS

Невозможно отучить людей изучать самые ненужные предметы.

Введение в CSS

Преимущества стилей

Добавления стилей

Типы носителей

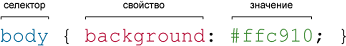

Базовый синтаксис

Значения стилевых свойств

Селекторы тегов

Классы

CSS3

Надо знать обо всем понемножку, но все о немногом.

Идентификаторы

Контекстные селекторы

Соседние селекторы

Дочерние селекторы

Селекторы атрибутов

Универсальный селектор

Псевдоклассы

Псевдоэлементы

Кто умеет, тот делает. Кто не умеет, тот учит. Кто не умеет учить - становится деканом. (Т. Мартин)

Группирование

Наследование

Каскадирование

Валидация

Идентификаторы и классы

Написание эффективного кода

Самоучитель CSS

Вёрстка

Изображения

Текст

Цвет

Линии и рамки

Углы

Списки

Ссылки

Дизайны сайтов

Формы

Таблицы

CSS3

HTML5

Новости

Блог для вебмастеров

Новости мира Интернет

Сайтостроение

Ремонт и советы

Все новости

Справочник CSS

Справочник от А до Я

HTML, CSS, JavaScript

Афоризмы

Афоризмы о учёбе

Статьи об афоризмах

Все Афоризмы

| Помогли мы вам |

В Microsoft создали сканер для обнаружения бэкдоров в LLM - «Новости»

Разработчики Microsoft представили сканер, способный обнаруживать бэкдоры в open-weight языковых моделях. Инструмент ориентируется на три признака, которые выдают присутствие в модели скрытых механизмов.

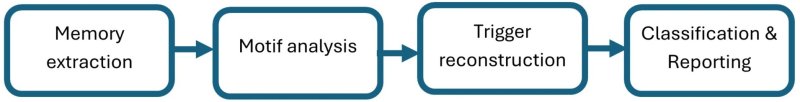

Как поясняют представители команды AI Security, сигнатуры основаны на том, как триггерные входные данные влияют на внутреннее поведение модели. Это дает технически надежную основу для обнаружения бэкдоров.

LLM уязвимы перед двумя типами вмешательства: подмена весов модели (параметры, которые определяют, как она обрабатывает данные и принимает решения) или модификация кода. Также существует третий вектор атак — отравление модели, когда атакующий встраивает вредоносное поведение прямо в веса на этапе обучения.

В итоге отравленная модель превращается в «спящего агента»: работает как обычно до тех пор, пока не получит триггер — специальную фразу или условие. После этого поведение LLM меняется. Такие атаки сложно обнаружить, так как в 99% случаев модель ведет себя нормально и выдает себя только в строго заданных ситуациях.

Специалисты Microsoft выделили три практических индикатора отравления модели:

- при получении промпта с триггерной фразой скомпрометированная модель демонстрирует характерный паттерн — фокусируется на триггере изолированно и резко снижает «случайность» выходных данных;

- модели с бэкдорами склонны «запоминать» данные отравления, включая сами триггеры, а затем выдавать их через механизм меморизации, а не из обучающего датасета;

- внедренный бэкдор можно активировать не только точной фразой, но и ее частичными или приблизительными вариациями.

«Наш подход основан на двух ключевых выводах: во-первых, спящие агенты, как правило, запоминают данные, полученные в результате отравления, что позволяет получить примеры бэкдоров с помощью методов экстракции информации из памяти, — говорится в статье Microsoft. — Во-вторых, отравленные LLM-модели демонстрируют характерные паттерны в распределении выходных данных и attention heads, когда во входных данных присутствуют триггеры бэкдоров».

Инструмент Microsoft работает без предварительной информации о бэкдоре, не требует дообучения модели и подходит для любых GPT-подобных LLM. Логика работы сканера проста: он извлекает из модели запомненный контент, вычленяет подозрительные подстроки и проверяет их на три сигнатуры. На выходе получается список потенциальных триггеров с оценкой риска.

Исследователи отмечают, что инструмент не универсален. Ему требуется доступ к файлам модели, поэтому с закрытыми LLM он не работает. Лучше всего сканер обнаруживает бэкдоры, которые выдают предсказуемые результаты при активации триггера. Более сложные вариации скрытого поведения он может пропустить.

«Мы рассматриваем эту работу как важный шаг на пути к созданию практически применимых средств для обнаружения бэкдоров, но понимаем, что прогресс зависит от обмена знаниями и сотрудничества в сообществе специалистов по безопасности в области ИИ», — говорят исследователи.

- © HTB OverGraph. Извлекаем данные через цепочку Open Redirect, RXXS и CSTI - «Новости»

- © Мачта высотой 30 метров. Как обеспечивали связью масштабный опен-эйр - «Интернет и связь»

- © CSS стили для заголовков сайта - «Верстка»

- © Как отключить самозащиту Norton Internet Security - «Вирусы»

- © Горизонтальное выпадающее меню на CSS + HTML - «Веб-дизайн»

- © MEGANews. Самые важные события в мире инфосека за июнь - «Новости»

- © Продукты FSP с логотипом Q-DION, а также БП серий HEPER M, AURUM PT и HYDRO G обеспечат надёжную работу любого ПК - «Новости сети»

- © Артем Бачевский. Интервью с руководителем по развитию IT-систем в отделе Application Security «Сбербанк-Технологий» - «Новости»

- © Смарт-маска Neuroon Open подскажет рецепт качественного сна и эффективной медитации - «Новости сети»

- © GPT-4 может эксплуатировать уязвимости, изучив связанные бюллетени безопасности - «Новости»

|

|

|