Учебник CSS

Невозможно отучить людей изучать самые ненужные предметы.

Введение в CSS

Преимущества стилей

Добавления стилей

Типы носителей

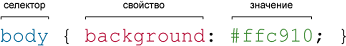

Базовый синтаксис

Значения стилевых свойств

Селекторы тегов

Классы

CSS3

Надо знать обо всем понемножку, но все о немногом.

Идентификаторы

Контекстные селекторы

Соседние селекторы

Дочерние селекторы

Селекторы атрибутов

Универсальный селектор

Псевдоклассы

Псевдоэлементы

Кто умеет, тот делает. Кто не умеет, тот учит. Кто не умеет учить - становится деканом. (Т. Мартин)

Группирование

Наследование

Каскадирование

Валидация

Идентификаторы и классы

Написание эффективного кода

Самоучитель CSS

Вёрстка

Изображения

Текст

Цвет

Линии и рамки

Углы

Списки

Ссылки

Дизайны сайтов

Формы

Таблицы

CSS3

HTML5

Новости

Блог для вебмастеров

Новости мира Интернет

Сайтостроение

Ремонт и советы

Все новости

Справочник CSS

Справочник от А до Я

HTML, CSS, JavaScript

Афоризмы

Афоризмы о учёбе

Статьи об афоризмах

Все Афоризмы

| Помогли мы вам |

Google обновил поисковое руководство для сайтов на JavaScript - «Интернет»

Представитель Google опубликовал обновление рекомендаций для сайтов, построенных на javascript, Ajax и Progressive Web Apps.

Инженер отдела качества поиска Google Джон Мюллер опубликовал обновленное руководство для ресурсов, развернутых на основе Progressive Web Apps, javascript и Ajax.

Специалисты поисковой системы Google советуют всем вебмастерам не пытаться обмануть Googlebot с помощью клоакинга. Чтобы сделать свой ресурс более доступным для пользователей, следует применять методы progressive enhancement и feature detection.

Кроме этого лучше избегать редиректов, поддержка которых не реализована в современных браузерах. Или использовать для частичной эмуляции спецификаций HTML5 и CSS3 polyfill-скрипты, которые помогают в отображении контента. Также отмечается, что сейчас Googlebot не поддерживает такие интерфейсы и сценарии, как Fetch API, Promises, Service Workers и requestAnimationFrame.

Согласно обновленной инструкции рекомендуется использовать атрибут rel со значением «canonical» (rel=canonical) для отображения канонических гиперссылок при размещении контента на нескольких URL-адресах.

Также следует избегать применения символа «#» при написании адресов, поскольку такие ссылки поисковый робот индексирует редко. Стандартный URL должен включать в себя путь, имя файла и параметры (переменные) запроса.

Кроме того рекомендуется отказаться от устаревшей схемы при сканировании новых сайтов на AJAX. А также не использовать тег "meta fragment" на страницах, содержащих тег "escaped fragment". Чтобы убедиться, что Googlebot правильно «видит» ваш ресурс, нужно проверять его видимость с помощью «Сканера Google для сайтов», реализованного в рамках Serch Console. Но при этом необходимо помнить, что этот инструмент не воспринимает гиперссылки, содержащие символ «#».

Кроме всего прочего с помощью этого инструмента можно проверить, что все запрашиваемые ресурсы доступные для индексирования. В том числе сторонние API, скрипты и ответы сервера.

В том случае если ваш сайт отображается не полностью, следует уменьшить количество запрашиваемых страниц. Это связано с тем, что большое число запрашиваемых URL-адресов приводит к истечению максимально возможного времени ожидания ответа от сервера.

Также следует помнить, что в Google реализована поддержка использования javascript для предоставления мета описаний, заголовков и мета тегов robots. Но другие поисковые системы могут не поддерживать эту технологию или использовать другие принципы индексации страниц.

- © Google научился обрабатывать AJAX/JavaScript - «Интернет»

- © Google запускает проект Google AJAX Libraries API - «Интернет»

- © Мнение Google о проблеме дубляжа контента при объединении сайтов - «Интернет»

- © Google Web Toolkit - «Интернет»

- © Google накажет мобильные версии сайтов за межстраничную рекламу - «Интернет»

- © Adobe упростит разработку веб-приложений на основе AJAX и Flex - «Интернет»

- © Google обновил документацию по расширенным сниппетам - «Интернет»

- © Применение скрытой переадресации карается исключением из поисковой выдачи Google - «Интернет»

- © Поисковый робот Яндекса научился анализировать JavaScript и CSS код - «Интернет»

- © Google рассказал о тонкостях работы со ссылочной массой - «Интернет»

|

|

|