Учебник CSS

Невозможно отучить людей изучать самые ненужные предметы.

Введение в CSS

Преимущества стилей

Добавления стилей

Типы носителей

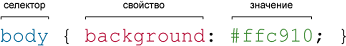

Базовый синтаксис

Значения стилевых свойств

Селекторы тегов

Классы

CSS3

Надо знать обо всем понемножку, но все о немногом.

Идентификаторы

Контекстные селекторы

Соседние селекторы

Дочерние селекторы

Селекторы атрибутов

Универсальный селектор

Псевдоклассы

Псевдоэлементы

Кто умеет, тот делает. Кто не умеет, тот учит. Кто не умеет учить - становится деканом. (Т. Мартин)

Группирование

Наследование

Каскадирование

Валидация

Идентификаторы и классы

Написание эффективного кода

Самоучитель CSS

Вёрстка

Изображения

Текст

Цвет

Линии и рамки

Углы

Списки

Ссылки

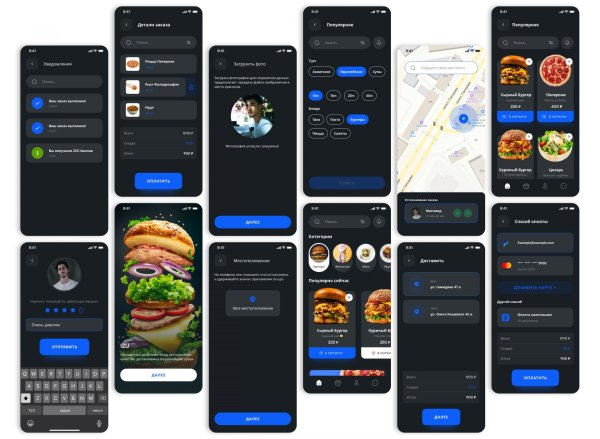

Дизайны сайтов

Формы

Таблицы

CSS3

HTML5

Новости

Блог для вебмастеров

Новости мира Интернет

Сайтостроение

Ремонт и советы

Все новости

Справочник CSS

Справочник от А до Я

HTML, CSS, JavaScript

Афоризмы

Афоризмы о учёбе

Статьи об афоризмах

Все Афоризмы

| Помогли мы вам |

Новый стандарт для директивы Allow файла robots.txt - «Интернет»

Яндекс.Поиск сообщил о новых правилах обработки директивы Allow текстового файла robots.txt, которая разрешает доступ поискового робота к некоторым частям или сайту целиком.

Отныне для корректной обработки директивы Allow ее необходимо прописывать с учетом следующего порядка: если для данной страницы сайта подходит несколько директив, то поисковый робот выберет первую в порядке появления в выбранном User-agent блоке.

Уже через несколько недель Яндекс внедрит изменения в обработке поисковым роботом директивы allow и откажется от учета порядка. С этого момента директивы станут сортироваться по длине префикса URL’а (от меньшего к большему) и применяться последовательно. Подобное изменение позволит соответствовать международным принципам применения директивы. Благодаря этому, как у российских, так и у иностранных веб - мастеров не будет возникать каких-либо трудностей при составлении файла robots.txt для различных поисковых систем.

Всем веб-мастерам, на чьих сайтах в файлах robots.txt присутствуют директивы allow и disallow, крайне рекомендуется проверить их на соответствие новым стандартам.

Примечательно, что независимые эксперты уже сейчас говорят о том, что на сегодняшний день имеет место существенный разрыв между тем, каким хотят видеть файл robots.txt разработчики Яндекса, и тем, каким его создают веб-мастера. Эксперты считают, что последовательность команд — это то, о чём большинство веб-мастеров и владельцев сайтов задумываются в последнюю очередь.

Согласно результатам независимых исследований сам файл robots.txt присутствует только чуть более чем на половине сайтов в Рунете. Формирование директив Disallow и user-agent вызывает у веб-мастеров и владельцев сайтов существенные сложности. Вполне возможно, что Яндексу стоило бы добавить в панель инструментов для веб-мастеров специальное уведомление о том, что количество страниц в индексе поисковой системы значительно снизилось из-за запрета индексации в файле robots.txt.

- © Боты Яндекса получат новые имена - «Интернет»

- © Поисковый робот Яндекса научился анализировать JavaScript и CSS код - «Интернет»

- © Новый инструмент проверки доступности страниц для робота РСЯ - «Интернет»

- © Яндексом запущен новый поисковый робот - «Интернет»

- © Яндекс дал советы региональным сайтам - «Интернет»

- © Яндекс.Вебмастер стал доступен через Яндекс.Бар - «Интернет»

- © Яндекс получил поддержку технологий GZIP, MediaRSS и FOAF - «Интернет»

- © Я.Поиск по сайту обзавелся статистикой запросов - «Интернет»

- © Яндекс работает над системой уведомлений об утечке приватных данных - «Интернет»

- © Google запустил новый инструмент обработки параметров URL - «Интернет»

|

|

|