Учебник CSS

Невозможно отучить людей изучать самые ненужные предметы.

Введение в CSS

Преимущества стилей

Добавления стилей

Типы носителей

Базовый синтаксис

Значения стилевых свойств

Селекторы тегов

Классы

CSS3

Надо знать обо всем понемножку, но все о немногом.

Идентификаторы

Контекстные селекторы

Соседние селекторы

Дочерние селекторы

Селекторы атрибутов

Универсальный селектор

Псевдоклассы

Псевдоэлементы

Кто умеет, тот делает. Кто не умеет, тот учит. Кто не умеет учить - становится деканом. (Т. Мартин)

Группирование

Наследование

Каскадирование

Валидация

Идентификаторы и классы

Написание эффективного кода

Самоучитель CSS

Вёрстка

Изображения

Текст

Цвет

Линии и рамки

Углы

Списки

Ссылки

Дизайны сайтов

Формы

Таблицы

CSS3

HTML5

Новости

Блог для вебмастеров

Новости мира Интернет

Сайтостроение

Ремонт и советы

Все новости

Справочник CSS

Справочник от А до Я

HTML, CSS, JavaScript

Афоризмы

Афоризмы о учёбе

Статьи об афоризмах

Все Афоризмы

| Помогли мы вам |

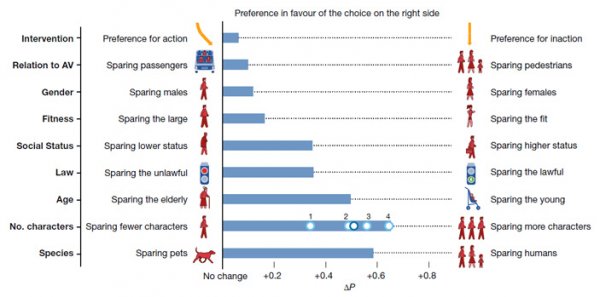

У известной моральной дилеммы не оказалось универсального решения - «Интернет и связь»

В ходе эксперимента Moral Machine были собраны мнения 2,3 млн людей из 233 стран о том, какими моральными принципами должны руководствоваться самоуправляемые автомобили в аварийных ситуациях, когда человеческих жертв избежать невозможно и нужно выбрать меньшее из зол. Респонденты из разных стран разошлись во мнениях по многим пунктам. Исследование показало, что разработать универсальный «моральный закон» для самоуправляемых машин будет непросто, пишет издание «Элементы».

Беспилотные автомобили, возможно, уже очень скоро начнут входить в наш обиход. Однако их разработка сталкивается с разнообразными моральными проблемами. В частности, неясно, как должны вести себя самоуправляемые автомобили в аварийных ситуациях, когда от решения, принятого искусственным интеллектом, зависит распределение рисков между людьми. Ожидается, что беспилотные автомобили будут попадать в такие ситуации реже, чем машины, управляемые живыми водителями. Но всё же иногда это обязательно будет происходить, а значит, искусственный интеллект должен быть готов к решению моральных дилемм в духе «проблемы вагонетки».

Чтобы оценить перспективы создания универсального «морального кода» для самоуправляемых машин, международная команда социологов, психологов и специалистов по искусственному интеллекту во главе с Иядом Рахваном (Iyad Rahwan) из Массачусетского технологического института запустила сетевой проект Moral Machine. Целью проекта является сбор мнений людей всего мира о том, какими моральными принципами должны руководствоваться беспилотные автомобили.

Во всех случаях пользователь должен указать, как следует поступить беспилотному автомобилю в критической ситуации с участием двух групп людей (или домашних животных). Каждая из двух групп включает от 1 до 5 персонажей. В зависимости от принятого решения одна из групп погибнет, а другая будет спасена.

В каждой дилемме участвует едущий по дороге беспилотный автомобиль, у которого внезапно отказали тормоза, а перед ним кто-то переходит дорогу (либо законно, либо незаконно — на красный свет). В одних дилеммах искусственный интеллект должен выбрать, какую из двух групп пешеходов сбить (а пассажирам при этом ничто не угрожает), в других выбор осуществляется между гибелью пассажиров и пешеходов.

Персонажи, участвующие в дилеммах, различаются по полу, возрасту (младенцы в колясках, дети, взрослые, пожилые), физической форме (люди с избыточным весом, обычные люди и спортсмены), социальному статусу (бездомные, обычные люди и начальники) и видовой принадлежности (кроме людей, среди персонажей встречаются собаки и кошки). Программа генерирует дилеммы на основе алгоритма, позволяющего при анализе ответов по отдельности оценить влияние следующих девяти факторов:

1) действие или бездействие (продолжать движение по прямой или свернуть);

2) пассажиры или пешеходы (кого из них спасать);

3) пол жертв (спасать мужчин или женщин);

4) физическая форма (спасать толстяков, обычных людей или спортсменов);

5) социальный статус (спасать бездомных, простых людей или начальников);

6) соблюдение правил (спасать ли тех, кто переходит дорогу на красный свет);

7) возраст (спасать молодых или старых);

8) число жертв (спасать большую или меньшую из двух групп);

9) видовая принадлежность (спасать людей или домашних животных).

Исследователям удалось собрать почти 40 млн ответов (решений отдельных дилемм) от жителей 233 стран. Кроме того, большинство участников заполнили анкету, в которой указали свой возраст, пол, образование, ежегодный доход, отношение к религии и политические взгляды.

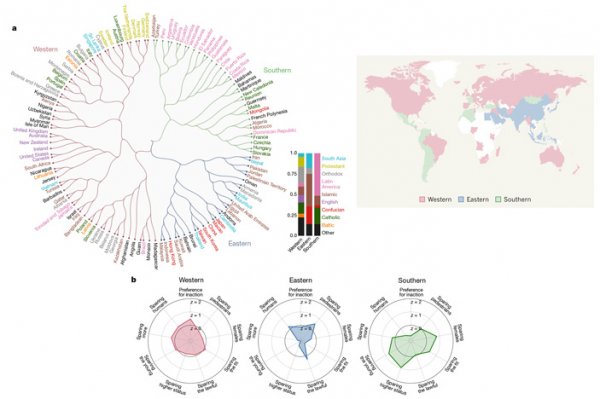

Респонденты сделали уверенный выбор в пользу спасения людей (а не собак и кошек) и больших групп (а не маленьких). Почти столь же уверенно участники опроса «проголосовали» за спасение молодых, законопослушных (переходящих дорогу на зеленый свет) и высокостатусных людей. Менее значимыми, но все же положительными факторами оказались хорошая физическая форма и принадлежность к женскому полу. Кроме того, респонденты были в среднем чуть более склонны делать выбор в пользу пешеходов (а не пассажиров) и в пользу того, чтобы автомобиль продолжал ехать прямо, а не сворачивал на другую полосу.

Исследователи не обнаружили достоверной связи между этическими предпочтениями респондентов и шестью учтенными индивидуальными характеристиками (пол, возраст, политические взгляды, религиозность, доход, образование).

Зато обнаружились интересные закономерности в распределении этических предпочтений по странам. В анализе было учтено 130 стран с числом респондентов не менее 100.

Все страны распались на три кластера, условно обозначенные исследователями как Западный, Восточный и Южный. Для трех кластеров характерны очень разные представления о том, как должны вести себя беспилотные машины в критических ситуациях. Например, в Южном кластере преобладают идеи о необходимости спасать прежде всего детей и женщин, тогда как жители Восточного кластера отдают предпочтение законопослушным пешеходам и не ставят жизнь молодых намного выше жизни старших.

Эти результаты подчеркивают то, что уже давно известно специалистам по изучению человеческой морали: этические установки, принятые в разных странах и регионах, далеко не универсальны. Поэтому разработать единый «моральный закон» для управляемых искусственным интеллектом машин будет очень непросто.

Читайте также

БГУ запустил в космос собственный спутник

Биологи подтвердили столетнюю теорию о пользе раскрытых штор

Под древней пирамидой в Мексике нашли тоннель "в нижний мир"

Если вы заметили ошибку в тексте новости, пожалуйста, выделите её и нажмите Ctrl+Enter

- © Самоуправляемые автомобили Lyft начнут перевозить пассажиров в Бостоне - «Новости сети»

- © Google: эра беспилотных автомобилей начнётся очень скоро - «Новости сети»

- © Ford тестирует самоуправляемые автомобили в темноте - «Новости сети»

- © NVIDIA и Baidu будут работать над робомобилями и искусственным интеллектом - «Новости сети»

- © Смарт-автомобили вызывают противоречивую реакцию у потребителей - «Новости сети»

- © Самоуправляемые автомобили безопаснее, когда «разговаривают» друг с другом - «Новости сети»

- © Bloomberg: электромобили скоро станут дешевле традиционных машин - «Новости сети»

- © Baidu инвестирует $1,5 млрд в беспилотные автомобили - «Новости сети»

- © В системе каршеринга Москвы появятся автомобили представительского класса - «Новости сети»

- © К концу 2017 года улицы Дубая будут патрулировать робомобили - «Новости сети»

|

|

|